코로나19로 인해 사회적으로 주목을 덜 받고 있지만, 4차 산업혁명은 계속 진행중이다.

4차 산업혁명의 핵심 주요 기술의 발전 방향에 대해 많은 이들이 기대와 우려를 표현하고 있다.

기술이 발전이 꼭 우리에게 편의만을 제공하지는 않음은 분명하다.

우리가 원하는 기술은 편리함과 함께 안전과 편안함까지 제공할 수 있어야 한다.

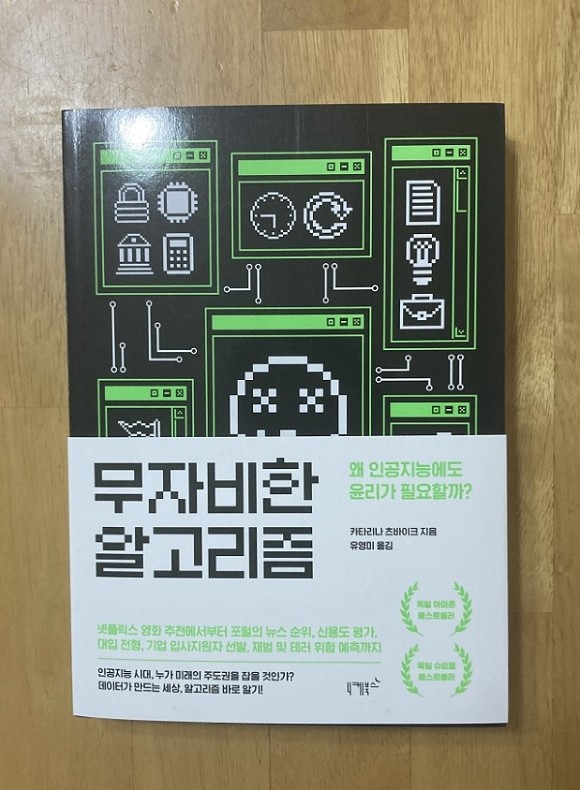

이 책 '무자비한 알고리즘'은 기술에 어떻게 편안함, 안전을 접목시킬 수 있는지를 말하고 있다.

책은 크게 3부로 나누어져 있다.

1부에서는 인공지능 시스템에 대해 이야기하고 있다.

인공지능 시스템의 기반이 되는 방법들을 소개하고, 어떻게 만드는지를 알려준다.

2부에서는 정보학의 ABC를 소개하고 있다.

ABC는 A(Algorithm, 알고리즘), B(Big Data, 빅데이터), C(Computer Intelligence, 컴퓨터 지능)를 뜻한다.

각각의 기능과 원리에 대해 설명하고 있는데, 인공지능을 만들기 위해 이 3가지가 유기적으로 잘 결합되어야 한다.

마지막 3부가 이 책의 핵심이자 주제이다.

이렇게 만들어진 인공지능에 앞서 말한 편리함과 안전과 같은 윤리적 기준을 어떻게 적용해야 하는지를 설명하고 있다.

정확히 말하면 적용이 아니라 개입이 맞는 표현이다.

알고리즘도 인간이 만들기에 오류가 있을 수 있지만, 오류가 없더라도 만든 인간이 의도한'대로만' 움직인다.

이것이 기계의 장점이자, 단점이다.

그렇기에 '적절한 시점'에 개입할 수 있는 여지를 두어야 하고, 해야 한다.

머신러닝에서는 원인을 탐구하는(인과 고리) 대신 중요한 사건과 종종 더불어 존재하는 행동양식이나 특성들을 확인한다.(상관관계)

그리고 알고리즘을 개발해 투입하기 전에 수학적 모델링을 거치는 고전적인 알고리즘 설계와는 달리, 머신러닝 알고리즘은 데이터로부터 세계의 모델을 만든다.

우리가 머신러닝의 효율성을 의미있게 활용하려면 컴퓨터가 발견한 상관관계에 대해 그간 해왔듯 자연과학적 의미에서 인과관계를 따져봐야 한다.

알고리즘을 만드는 방식의 차이를 설명하고 있다.

기존의 모델은 수학적 설계에 기반하였는데, 인공지능은 데이터를 기반으로 한다.

그렇기에 다양한 상관관계를 유추할 수 있다.

이는 우리가 몰랐던 것을 찾을 수도 있지만, 상당히 억지스러운(?) 것도 볼 수 있다.

대표적인 예가 '맥주-기저귀'의 관계일 것이다.

한때 마트에서 맥주 코너에 가면 기저귀를 볼 수 있었다.

무척 생뚱맞은 조합이라 생각했는데, 알고리즘은 맥주를 구입한 고객이 기저귀도 함께 구입한다고 판단했기에 그렇게 진열한 듯 하다.

단지 데이터만 가지고 추출한 관계에는 '인과관계'보다는 '상관관계'만 중요시 되기에 이와 같은 현상이 발생할 수 있다.

누가 알고리즘 사용에 책임이 있는가?

알고리즘 설계사들이 알고리즘을 정확히 어디에 사용할지를 잘 알고 사용을 감독할 수 있는 경우, 결과에 대한 그들의 책임은 크다.

내 알고리즘이 정확히 내가 알고 있는 맥락에서 사용되면, 그것은 내가 프로그래밍한 대로 행동한다.

그러면 그 결과는 내 책임이다.

알고리즘도 결국 사람이 만든다.

즉, 쓰임에 대해 정확히 인지하고, 그것에 맞게 적절하게 만들었다면 책임은 만든 사람의 몫이다.

하지만 의도하지 않은 곳에 사용되었다면 책임을 전가할 수 없다.

광산 폭파를 위해 다이너마이트르 만든 노벨이나 상댕성 이론을 발견한 아인쉬타인도 그들의 지식이 사람을 살상하는데 쓰이게 되리라 전혀 생각하지 못햇을 것이다.

빅데이터의 세 가지 주요 특징은 다음과 같다.

1) 정보량이 방대하다.(Volumn : 양)

2) 종종 단기간에 생성되고 처리된다.(Velocity : 속도)

3) 여러 혈태의 데이터가 섞여 있다.(Variety : 다양성)

빅데이터에 대한 오해 중 하나가 '모든 데이터'가 빅데이터라는 것이다.

절대 그렇지 않다.

위와 같은 특징을 가지고 있어야 '빅 데이터'로 인정받을 수 있다.

머신러닝은 다음 조건이 충족될 때 기본적으로 성공적일 수 있다.

1) 양질의 방대한 트레이닝 데이터가 있을 때

2) 측정가능한 실측자료, 즉 예측할 수 있는 것이 있을 때

3) 인풋과 예측할 수 있는 아웃풋 사이에 인과관계가 있을 때

머신러닝 알고리즘이 인간을 능가하는 면은 다음과 같다.

1) 임의의 데이터에서 상관관계를 찾을 수 있다는 점

2) 다양한 상관관계를 찾을 수 있다는 점

3) 약한 상관관계도 통계 모델에 집어넣어 유익을 이끌어 낼 수 있다는 점

추가적으로 다음에 해당될 때 머신러닝의 결과는 믿을 만하다.

1) 인풋과 예측되는 아웃풋 사이에 인과관계가 알려져 있어 관계자들이 쉽게 합의할 수 있는 명확한 인풋 데이터가 존재할 때

2) 두 가지 오류 유형(위양성/위음성 결정)에 대해 가급적 많은 피드백이 있을 때, 그로써 지속적으로 품질을 측정해 통계 모델을 역동적으로 개선할 수 있다.

3) 모든 관계자들이 쉽게 동의할 수 있는 명확한 품질 척도가 있을 때

머신러닝은 만능이 아니다.

머신러닝이 인간보다 잘하는 것이 있고, 그렇지 않은 것이 있다.

적절한 곳에 사용하여 생산성을 높이고, 그렇지 않은 곳에서는 인간이 개입하여 통제해야 한다.

이 책은 우리가 머신러닝에 대한 맹신과 우려를 함께 보여주고 있다.

머신러닝을 통해 얻을 수 있는 부분과 그렇지 않은 부분을 구분하여 사용하면 된다.

그리고 제대로 작동하고 있는지에 대해 철저한 모니터링이 필요하다.

알고리즘은 '무자비'한 것이 아니라, 입력하고 프로그래밍한 그대로 보여주는 '정확한' 것이다.

자비를 넣는 것은 아직 인간의 몫이다.